Возможно, сайт был подвергнут блокировке из-за нарушения закона, а может этот сайт просто пока что не отвечает на запрос. Как бы ни была причина, иногда вам нужно взять какую информацию с сайта, который совсем недавно перестал работать или был взломан и лишился всего контента. В большинстве случаев удача может повернуться к вам лицом. Вы можете просмотреть кэшированную версию этого сайта в Google?

Кэшированные сайты: что это?

Для того чтобы быстро отыскать все эти сайты, Google и другие поисковые системы сохраняют внутреннюю копии этих сайтов на серверах. Эти сохраненные файлы и называются кэшем, и Google позволяет их просматривать, если такая копия существует. Раньше этот процесс был очень понятен – вам просто нужно было нажать ссылку, представленную под результатом, выданном в поиске. Сейчас все немного сложнее, но вам не стоит беспокоиться, так как кэшированные сайты по-прежнему существуют.

Смотрим кэш сайта в Гугл :

1. Попробуйте найти что-нибудь. В данном случае, мы будем искать по ключу «кеширование», и предположим, что в коем-то веке Wikipedia ушла в даун.

2. Наведите курсор мыши на результат поиска, но не кликайте.

3. Вы увидите, что рядом справа от результата появится стрелка вправо. Кликните по этой стрелке.

4. Теперь вы можете видеть миниатюру сайта. Вы также увидите ссылку Cached сверху от миниатюры. Можете кликать по этой ссылке.

Таким образом, вы будете перенаправлены к кэшированной версии сайта. И эта версия не обязательно будет содержать актуальные данные. Это просто копия сайта в том состоянии, в котором бот Google последний раз его сканировал, и на самом деле эта страница хранится на сервере Google, и поэтому ссылка будет начинаться с webcache.googleusercontent.com, а не с Wikipedia.org. Google также расскажет вам о том, насколько свежая эта копия.

Иногда бывает так, что на страницах отсутствуют изображения или фоны. Вы можете кликнуть по ссылке в верхней части страницы и увидеть текстовую версию сайта, который вы на данный момент читаете. Иногда это помогает найти необходимую вам информацию. Вы также можете кликнуть по ссылке, которая приведет вас к актуальной странице, если вам вдруг нужно будет сравнить две эти версии.

Если вам нужно найти определенный термин, вы можете воспользоваться сочетанием клавиш Ctrl+F, и просто отыскать его при помощи вашего браузера.

Сайты, которые не кэшируются

У большинства сайтов есть кэшированные копии, но бывают и исключения. Владельцы сайтов могут использовать файл robots.txt для того, чтобы попросить поисковую систему не индексировать сайт, либо удалять кэш. Иногда такое бывает, когда владелец хочет полностью удалить сайт, и не хочет, чтобы где-то появлялся его контент. Ведь существует довольно много сайтов с «черным» контентом или контентом, который не обязательно должен индексироваться (приватные форумы, информация о кредитных картах или сайты с платным доступом к контенту).

Вы можете проследить за тем, как изменялся сайт, воспользовавшись инструментом от Google под названием WebArchive , но функционал этого инструмента также может быть запрещен файлом robots.txt.

20 июня 2012 в 18:28Достаём потерянные статьи из сетевых хранилищ

- Разработка веб-сайтов

Решение рассматривается (пока) только для одного сайта - того, на котором мы находимся. Идея появилась в результате того, что один пользователь сделал юзерскрипт, который переадресует страницу на кеш Гугла, если вместо статьи видим «Доступ к публикации закрыт». Понятно, что это решение будет работать лишь частично, но полного решения пока не существует. Можно повысить вероятность нахождения копии выбором результата из нескольких сервисов. Этим стал заниматься скрипт HabrAjax (наряду с 3 десятками других функций). Теперь (с версии 0.859), если пользователь увидел полупустую страницу, с которой можно перейти лишь на главную, в личную страницу автора (если повезёт) и назад, юзерскрипт предоставляет несколько альтернативных ссылок, в которых можно попытаться найти потерю. И тут начинается самое интересное, потому что ни один сервис не заточен на качественное архивирование одного сайта.

Кстати, статья и исследования порождены интересным опросом и скриптом пользователя - комментарий .

Требуется, конечно, более качественный сервис, поэтому, кроме описания нынешней скромной функциональности (вероятность найти в Гугл-кеше и на нескольких сайтах-копировщиках), поднимем в статье краудсорсинговые вопросы - чтобы «всем миром» задачу порешать и прийти к качественному решению, тем более, что решение видится близким для тех, кто имеет сервис копирования контента. Но давайте обо всём по порядку, рассмотрим все предложенные на данный момент решения.

Кеш Гугла

В отличие от кеша Яндекса, к нему имеется прямой доступ по ссылке, не надо просить пользователя «затем нажать кнопку „копия“». Однако, все кеширователи, как и известный archive.org, имеют ряд ненужных особенностей.1) они просто не успевают мгновенно и многократно копировать появившиеся ссылки. Хотя надо отдать должное, что к популярным сайтам обращение у них частое, и за 2 и более часов они кешируют новые страницы. Каждый в своё время.

3) поэтому результат кеширования - как повезёт. Можно обойти все такие кеширующие ссылки, если очень надо, но и оттуда информацию стоит скопировать себе, потому что вскоре может пропасть или замениться «более актуальной» бессмысленной копией пустой страницы.

Кеш archive.org

Он работает на весь интернет с мощностями, меньшими, чем у поисковиков, поэтому обходит страницы какого-то далёкого русскоязычного сайта редко. Частоту можно увидеть здесь:Да и цель сайта - запечатлеть фрагменты истории веба, а не все события на каждом сайте. Поэтому мы редко будем попадать на полезную информацию.

Кеш Яндекса

Нет прямой ссылки, поэтому нужно просить (самое простое) пользователя нажать на ссылку «копия» на странице поиска, на которой будет одна эта статья (если её Яндекс вообще успел увидеть).Как показывает опыт, статья, повисевшая пару часов и закрытая автором, довольно успешно сохраняется в кешах поисковиков. Впоследствии, скорее всего, довольно быстро заменится на пустую. Всё это, конечно, не устроит пользователей веба, который по определению должен хранить попавшую в него информацию.

Из живых я нашёл пока что 4, некоторые давно существовавшие (itgator) на данный момент не работали. В общем, пока что они почти бесполезны, потому что заставляют искать статью по названию или ключевым словам, а не по адресу, по которому пользователь пришёл на закрытую страницу (а по словам отлично ищет Яндекс и не только по одному их сайту). Приведены в скрипте для какой-нибудь полезной информации.

Задача

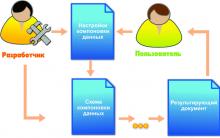

Перед сообществом стоит задача, не утруждая организаторов сайта, довести продукт до качественного, не теряющего информацию ресурса. Для этого, как правильно заметили в комментариях к опросу, нужен архиватор актуальных полноценных статей (и комментариев к ним заодно).В настоящее время неполное решение её, как описано выше, выглядит так:

Если искать в Яндексе, то подобранный адрес выведет единственную ссылку (или ничего):

Нажав ссылку «копия», увидим (если повезёт) сохранённую копию (страница выбрана исключительно для актуального на данный момент примера):

В Гугле несколько проще - сразу попадаем на копию, если тоже повезёт, и Гугл успел сохранить именно то, что нам надо, а не дубль отсутствующей страницы.

Забавно, что скрипт теперь предлагает «выбор альтернативных сервисов» и в этом случае («профилактические работы»):

Жду предложений по добавлению сервисов и копировщиков (или хотя бы проектов) (для неавторизованных - на почту spmbt0 на известном гуглоресурсе, далее выберем удобный формат).

UPD

23:00: опытным путём для mail.ru

было выяснено строение прямой ссылки на кеш:

"http://hl.mailru.su/gcached?q=cache:"+ window.location

Знатоки или инсайдеры, расскажите, что это за ссылка, насколько она стабильна (не изменится ли, например, домен 3-го уровня), что значит приставка «g»-cached? Значит ли это кеш Гугла или это кеш движка Gogo?

Кэш (cache) браузера - это папка с копиями некоторых данных со страниц, которые вы посещали. Обычно в кэше сохраняются те элементы страницы, которые вряд ли успели измениться за промежуток времени между двумя запросами, - музыка, видео, изображения, стили, скрипты. При повторном просмотре страниц Яндекс.Браузер уже не будет запрашивать эти данные из интернета, а извлечет их из кэша. Использование кэша снижает нагрузку на сеть и повышает скорость загрузки страниц.

Пример использования кэша

Когда вы начинаете смотреть онлайн-видео, отображаются указатели и просмотренного и загруженного видео. После полной загрузки можно отключиться от интернета и досмотреть ролик или фильм. Загруженное видео сохраняется в кэше на вашем компьютере и в дальнейшем считывается с локального жесткого диска.

","hasTopCallout":true,"hasBottomCallout":true,"areas":[{"shape":"circle","direction":["bottom","right"],"alt":"Доля просмотренного видео","coords":,"isNumeric":false,"hasTopCallout":false,"hasBottomCallout":true},{"shape":"circle","direction":["top","right"],"alt":"Доля загруженного в кэш видео","coords":,"isNumeric":false,"hasTopCallout":true,"hasBottomCallout":false}]}}">

Приватность и кэш

Сохранение данных в кэше несет следующие риски для вашей приватности:

- Если доступ к компьютеру имеют несколько пользователей, любой из них может увидеть в папке с кэшем изображения, которые вы ранее просматривали. Рекомендуем использовать на таких компьютерах режим Инкогнито .

- Если на компьютере присутствует вредоносное ПО, то оно может получить доступ к кэшу браузера.

Интернет - вещь абсолютно не постоянная. Любой сайт в силу различных обстоятельств (обрывы линий электропередач, банкротство хостера, неоплата домена) может перестать работать. В браузерах пользователей после этого отобразятся только сообщения о недоступности любимого ресурса. Если же сайт изменится до неузнаваемости, а страницу с важной информацией удалит администрация, ресурс продолжит свою работу, но конечному потребителю неприятностей в этом случае не избежать.

Не стоит волноваться и проклинать злой рок. Быть может, портал недоступен временно, а специалисты заняты восстановлением его работы. Помимо этого, у каждого пользователя Глобальной сети есть мощный инструмент, который позволит получить необходимую информацию, - кэш сайтов.

Google - мегакорпорация, мощности серверов которой имеют возможность постоянно сканировать Интернет на предмет появления новых страниц и изменения старых. Добавляя ресурсы в свою базу, алгоритмы не только но и делают их снимки. Грубо говоря, Google создает резервные копии Интернета на тот случай, если исходный материал станет недоступным.

Кэш сайтов Google доступен всем без исключения. Чтобы получить доступ к любой проиндексированной странице, в строку поисковика требуется ввести запрос: . На экране отобразится копия страницы, в верхней части экрана будет показана следующая информация:

- Дата последнего сохранения, что даст возможность судить, могла ли измениться представленная информация.

- Здесь же располагается ссылка на снимок, в котором содержится только текст.

- Еще один URL покажет полный исходный код, который заинтересует веб-мастеров.

Владельцам ресурсов в Интернете нужно знать, что кэш сайтов компании Google - добровольная в использовании система. Если необходимо исключить какие-либо страницы вашего портала из списка сохраненных, можно запретить делать снимки. Для этого на страницу нужно добавить метатег . Также запретить или разрешить кэширование можно в рабочем кабинете, если вы имеете соответствующий аккаунт.

Если же вам нужно удалить уже сохраненные снимки из кэша Google, потребуется отправить электронное письмо с запросом, а потом подтвердить свои права на сайт.

"Яндекс"

На втором месте в списке компаний, сохраняющих кэш сайтов, располагается отечественный гигант индустрии. Охват "Яндекса" намного меньше, поэтому здесь стоит искать в основном снимки крупных, обладающих высокой посещаемостью ресурсов.

Просто введите в поисковую строку URL нужной страницы и нажмите ENTER. Результаты поиска покажут необходимый вам сайт на первом месте выдачи. Рядом со ссылкой на него будет располагаться иконка в виде треугольника. Кликнув на нее и выбрав пункт меню «сохраненная копия», откроете последний доступный снимок страницы.

The Wayback Machine

В 1996 году Брюстер Кейл открыл некоммерческую организацию, которую сейчас называют архивом Интернета. Компания занимается сбором копий веб-страниц, видеоматериалов, графических изображений, аудиозаписей, программного обспечения. Собранный материал архивируется, а бесплатный доступ к нему может получить любой желающий.

Главная цель The Wayback Machine - сохранение культурных ценностей, созданных цивилизацией после широкого распространения Интернета, создание наиболее полной электронной библиотеки человечества. В настоящий момент в Архиве хранится более 10 петабайт данных, что позволяет пользователям ознакомиться с 85 миллиардами веб-страниц. Это значит, Архив - наиболее полный кэш сайтов.

Archive.org - сайт организации, на нем можно попытаться найти снимок необходимой страницы. Так как сохраняется не только последняя копия, а бот просматривает ресурсы периодически, можно изучить все изменения, сделанные на определенной странице с течением времени, даже если сайт уже не существует. В строке поиска желательно использовать префикс WWW.

Dead URL

«Мертвый адрес» предоставляет для пользователей похожие возможности. Скопируйте из нерабочий URL и вставьте его в поле ввода на сайте. Сервис немного подумает и выдаст несколько результатов. Некоторые из них будут ссылаться на ресурс компании Google. Другая часть приведет пользователя на страницы Архива. Что немаловажно, сортируется кэш сайтов по дате, а это очень удобно.

Down Or Not

Если вам необходим кэш сайтов в Интернете в связи с недоступностью того или иного ресурса, но поиски ни к чему не приводят, стоит проверить, не рядом ли с вами проблема. Например, провайдер Интернета выполняет технические работы или заменяет устаревшее оборудование. Для проверки, кто виноват, есть смысл воспользоваться сервисом Down Or Not (Жив или нет).

Введите адрес необходимого вам портала в строку поиска и нажмите на кнопку ENTER. После недолгого анализа сервис выдаст результат. Слово DOWN указывает на недоступность ресурса (временную или постоянную), если же на экране появится слово UP - значит, с порталом всё в порядке.

Down Ot Not выступает в роли стороннего и непредвзятого эксперта, чтобы определить, что именно является источником проблемы.

Иногда, зайдя на (ранее существовавшую) страницу, мы получаем 404 ошибку — страница не найдена. Эта страница удалена, сайт не доступен и т. д., но как просмотреть удалённую страницу ? Попробую дать ответ на этот вопрос и предложить четыре готовых варианта решения этой задачи.

Вариант 1: автономный режим браузера

Для экономии трафика и увеличения скорости загрузки страниц, браузеры используют кэш. Что такое кэш? Кэш (от англ. cache ) — дисковое пространство на компьютере, выделенное под временное хранение файлов, к которым относятся и веб-страницы.

Так что попробуйте просмотреть удаленную страницу из кэша браузера. Для этого — перейдите в автономный режим .

Примечание : просмотр страниц в автономном режиме возможен, только если пользователь посещал страницу ранее и она ещё не удалена из кэша.

Как включить автономный режим работы браузера?

Для Google Chrome , Яндекс.Браузер и др., автономный режим доступен только как эксперимент. Включите его на странице: chrome://flags/ — найдите там «Автономный режим кеша» и кликните ссылку «Включить ».

Включение и выключение автономного режима в браузере Google Chrome

Включение и выключение автономного режима в браузере Google Chrome

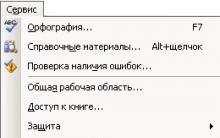

В Firefox (29 и старше) откройте меню (кнопка с тремя полосками) и кликнуть пункт «Разработка » (гаечный ключ) , а потом пункт «Работать автономно ».

Включение и выключение автономного режима в браузере Firefox

Включение и выключение автономного режима в браузере Firefox

В Opera кликните кнопку «Opera», найдите в меню пункт «Настройки », а потом кликните пункт «Работать автономно ».

Как включить или отключить автономный режим в Opera?

Как включить или отключить автономный режим в Opera?

В Internet Explorer — нажмите кнопку Alt , (в появившемся меню) выберите пункт «Файл » и кликните пункт меню «Автономный режим ».

Как отключить автономный режим в Internet Explorer 11?

Уточню — в IE 11 разработчики удалили переключение автономного режима. Возникает вопрос — как отключить автономный режим в Internet Explorer 11? Выполнить обратные действия — не получится, сбросьте настройку браузера.

Для этого закройте запущенные приложения, в том числе и браузер. Нажмите комбинацию клавиш Win +R и (в открывшемся окне «Выполнить») введите: inetcpl.cpl , нажмите кнопку Enter . В открывшемся окне «Свойства: Интернет» перейдите на вкладку «Дополнительно ». На открывшейся вкладке найдите и кликните кнопку «Восстановить дополнительные параметры », а потом и появившуюся кнопку «Сброс… ». В окне подтверждения установите галочку «Удалить личные настройки » и нажмите кнопку «Сброс ».

Вариант 2: копии страниц в поисковиках

Ранее я рассказывал , что пользователям поисковиков ненужно заходить на сайты — достаточно посмотреть копию страницы в поисковике, и это хороший способ решения нашей задачи.

В Google — используйте оператор info: , с указанием нужного URL-адреса. Пример:

В Яндекс — используйте оператор url: , с указанием нужного URL-адреса. Пример:

Наведите курсор мыши на (зелёный) URL-адрес в сниппете и кликните появившуюся ссылку «копия ».

Проблема в том, что поисковики хранят только последнюю проиндексированную копию страницы. Если страница удалена, со временем, она станет недоступна и в поисковиках.

Вариант 3: WayBack Machine

Сервис WayBack Machine — Интернет архив, который содержит историю существования сайтов.

Просмотр истории сайта на WayBack Machine

Просмотр истории сайта на WayBack Machine

Введите нужный URL-адрес, а сервис попытается найти копию указанной страницы в своей базе с привязкой к дате. Но сервис индексирует далеко не все страницы и сайты.

Вариант 4: Archive.today

Простым и (к сожалению) пассивным сервис для создания копий веб-страниц является Archive.today . Получить доступ к удалённой странице можно, если она была скопирована другим пользователем в архив сервис. Для этого введите URL-адрес в первую (красную) форму и нажать кнопку «submit url ».

После этого, попробуйте найти страницу, используя вторую (синюю) форму.

Рекомендую! Подумал: А что делать, если страница не удалена? Бывает же так, что просто невозможно зайти на сайт. Нашел статью Виктора Томилина , которая так и называется «Не могу зайти на сайт » — где автор не просто описывает 4 способа решения проблемы, но и записал наглядное видео.

| в 22:40 | Изменить сообщение | 12 комментариев |

Антивирус Bitdefender: эффективный защитник Без вопросов

Значение слова неудачный

Обзор Samsung Galaxy A7 (2017): не боится воды и экономии Стоит ли покупать samsung a7

Делаем бэкап прошивки на андроиде

Как настроить файл подкачки?