(Информационно-измерительные подходы для оценки качества технических средств хронометрии)

(Теория электрической связи)

Скорость передачи информации и пропускная способность дискретного канала без помех

Передача информации происходит во времени, поэтому можно ввести понятие скорости передачи как количество информации, передаваемой в среднем за единицу времени. Для эргодических последовательностей сообщений, где допускается усреднение во времени, скорость передачи равна: Здесь J(aT) - количество информации,...Пропускная способность непрерывного канала связи

Пусть сигнал на выходе канала равен сумме входного сигнала и присутствующего в канале нормального шума: а статистические свойства сигнала и смеси сигнала и шума описываются «-мерными плотностями вероятности: Если канал имеет ограниченную ширину полосы пропускания Р, то смесь сигнала и шума...(Теория электрической связи)

Сети с заданными пропускными способностями узлов и связей.

Пусть в сети N= (К, R) заданы пропускные способности связей санузлов g;,j= 1,2,..., | к |. Необходимо найти максимальный поток между источником 5 и стоком /, при этом полный поток, входящий в узел Хр не должен превышать^ для всех j. Такая задача возникает,...(Основы функционирования систем сервиса)

Скорость передачи информации и пропускная способность дискретных каналов с помехами

Отличительной особенностью рассмотренных ранее каналов без помех является то, что при выполнении условия теоремы Шеннона количество принятой информации на выходе канала всегда равно количеству информации, переданной от источника сообщений. При этом, если на вход канала поступил сигнал щ, то на выходе...(Теоретические основы информационных процессов и систем)

Соотношения (7.1)–(7.3), определяющие скорость передачи и пропускную способность канала и линии связи, являются общими, и поэтому они применимы как для дискретных, так и для непрерывных каналов, как для каналов без шумов, так и для каналов с шумами. Разница заключается в способе вычисления количества информации, содержащейся в последовательности выходных сигналов Z T , о входных сигналах Y T , т.е. I (Z T , Y T ).

Для вычисления I (Z T , Y T ) можно использовать соотношения (5.30) или (5.31). Из этих соотношений получаем

I(Z T ,Y T) = H(Z T) – H(Z T | Y T) = H(Y T) – H(Y T | Z T). (8.9)

Будем полагать, что шумы, действующие в канале связи, имеют эргодический характер. Это значит, что, например, при длительной многократной передаче сигнала у i сигналы z на выходе канала с вероятностью, как угодно близкой к единице, образуют типичную последовательность. То же самое справедливо и при передаче эргодической последовательности различных сигналов у. При таком условии выход канала связи может рассматриваться как эргодический источник.

Для последовательности длительностью Т, содержащей М сигналов такого источника, имеем

H(Z T) = MH(Z), (8.10)

где H(Z) – энтропия выходного сигнала или, точнее, энтропия выхода канала связи, рассматриваемого как эргодический источник.

Величина H(Z) может быть подсчитана по формуле, аналогичной (6.10),

H(Z) = (8.11)

При этом Q l и Q k обозначены характерные состояния выхода канала связи.

Такое же соотношение получим и для вычисления условной энтропии

H(Z T | Y T) = MH(Z | Y), (8.12)

где H(Z |Y) – энтропия выходного сигнала канала связи при известных входных сигналах.

Повторяя рассуждения, приведенные при выводе (6.10), получим

H(Z |Y) = (8.13)

При этом p(Q l | Q k , y j) – условная вероятность перехода выхода канала связи из состояния Q k в состояние Q l при передаче сигнала y j .

Из (8.9), (8.10) и (8.12) следует, что

I(Z T , Y T) = MH(Z) – MH(Z | Y).

При определении скорости передачи информации по (7.3 ’) учтем, что ; при этом, как и ранее, - средняя длительность сигнала одного сообщения. Тогда получим

Повторяя рассуждения, аналогично найдем

В последнем равенстве - поток информации на выходе кодирующего устройства, характеризует потерю информации, обусловленную действием помех.

Из найденных соотношений и (7.3) следует, что пропускная способность канала связи при наличии помех может быть определена из условия

Оба определения равноправны и дают одно и то же значение С с. Использование того или иного определения дикдуется удобством анализа. При отыскании оптимальных статистических характеристик передаваемых сигналов (у ) необходимо иметь в виду следующее:

Характерные состояния выхода канала связи (Q k , Q l ) могут определяться двумя обстоятельствами:

а) наличием фиксированных ограничений, т.е. запретов, накладываемых на допустимую последовательность передачи различных сигналов, и

б) коррелятивными связями между символами, вызываемыми действием шумов.

Каналы, у которых на каждый передаваемый сигнал (символ) шум воздействует независимоот того, какие сигналы передавались ранее, называются каналами без памяти. В этих каналах шумы не вызывают дополнительных коррелятивных связей между сигналами. В настоящее время основные выводы теории информации получены применительно к каналам без памяти.

Проиллюстрируем вычисление пропускной способности канала на следующем примере.

Пусть требуется определить пропускную способность канала связи, по которому передаются двоичные сигналы со скоростью v x , если вероятность превращения в результате действия помех каждого из этих сигналов в противоположный равна р (вероятность правильного приема, следовательно, 1 – р ). Передаваемые сигналы предполагаются независимыми.

Рис. 8.3. Двоичный симметричный канал

В этом случае алфавит Х и алфавит Y состоят из двух символов: Х = (х 1 ,х 2), Y =(у 1 , у 2). Диаграмма рис. 8.3 показывает возможные варианты передачи и соответствующие им вероятности. Такой канал называется симметричным.

Средняя условная энтропия

Но p (x 1) + p (x 2)=1.

H (Y ôX )= -p log p – (1 – p )log (1 – p ).

Отсюда видно, что H (Y ôX )не зависит от характеристик источника, т.е. от р (х 1)и р (х 2),и определятся только помехами в канале передачи.

Максимальное количество информации на один символ получается, следовательно, при таком распределении вероятностей р (х i ),при котором оказывается максимальным член H (Y ). Но H (Y )не может превосходить величины

H m (Y )= log m =log 2

(что достигается при р (х 1)= р (х 2)=1/2.Поэтому имеем:

max{I (Y , X ) = log 2 + p log p + (1 – p )log (1 – p )

и, следовательно, пропускная способность

C = v x max {I (Y , X )} =

= v x . (8.19)

Отсюда следует, в частности, что при p = 0,т.е. при отсутствии шумов в канале, имеем максимальное значение С

С max = v x log 2.

При р =1 также имеем детерминированный случай, когда сигналы х 1 переводятся в сигналы х 2 и наоборот с вероятностью, равной единице. При этом пропускная способность канала также максимальна.

Минимальное значение пропускная способность имеет при p =1/2(C max = 0).

Если на вход канала подаются сигналы от всех возможных источников дискретных сообщений с одинаковым количеством символов в единицу времени u = 1/T и числом элементарных символов т, то выражение для С и, соответственно, для пропускной способности канала в расчете на единицу времени выглядит так:

Отсюда при т = 2 имеем (8.19).

Пропускная способность систем передачи информации

Одной из основных характеристик любой системы передачи информации, кроме перечисленных выше, является ее пропускная способность.

Пропускная способность – максимально возможное количество полезной информации, передаваемое в единицу времени:

c = max{Imax} / TC ,

c = [бит/с].

Иногда скорость передачи информации определяют как максимальное количество полезной информации в одно элементарном сигнале:

s = max{Imax} / n,

s = [бит/элемент].

Рассмотренные характеристики зависят только от канала связи и его характеристик и не зависят от источника.

Пропускная способность дискретного канала связи без помех. В канале связи без помех информацию можно передавать неизбыточным сигналом. При этом число n = m, а энтропия элементарного сигнала HCmax = logK.

max{IC} = nHCmax= mHCmax .

Длительность элементарного сигнала , где – длительность элементарного сигнала.

где FC – спектр сигнала.

Пропускная способность канала связи без помех

![]()

Введем понятие скорости генерации элементарного сигнала источником информации:

Тогда, используя новое понятие, можно преобразовать формулу для скорости передачи информации:

Полученная формула определяет максимально возможную скорость передачи информации в дискретном канале связи без помех. Это следует из предположения о том, что энтропия сигнала максимальна.

Если HC < HCmax, то c = BHC и не является максимально возможной для данного канала связи.

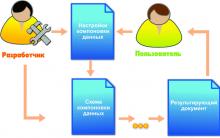

Пропускная способность дискретного канала связи с помехами. В дискретном канале связи с помехами наблюдается ситуация, изображенная на рис. 6.

Учитывая свойство аддитивности, а также формулы Шеннона для определения количества информации, рассмотренные выше, можно записать

IC = TC FC log(AK PC),

IПОМ = TП FП log(APП).

Для получателя источник полезной информации и источник помехи равноценны, поэтому нельзя на приемной стороне выделить составляющую помехи в сигнале с результирующей информацией

IРЕЗ = TC FC log(AK (PП + PC)), если TC = TП, FC = FП.

Приемник может быть узкополосным, а помеха находиться в других интервалах частот. В этом случае она не будет влиять на сигнал.

Будем определять результирующий сигнал для наиболее “неприятного” случая, когда параметры сигнала и помехи близки друг к другу или совпадают. Полезная информация определяется выражением

Эта формула получена Шенноном. Она определяет скорость передачи информации по каналу связи в случае, если сигнал имеет мощность PC, а помеха – мощность PП. Все сообщения при такой скорости передадутся с абсолютной достоверностью. Формула не содержит ответа на вопрос о способе достижения такой скорости, но дает максимально возможное значение с в канале связи с помехами, то есть такое значение скорости передачи, при которой полученная информация будет абсолютно достоверной. На практике экономичнее допустить определенную долю ошибочности сообщения, хотя скорость передачи при этом увеличится.

Рассмотрим случай PC >> PП. Если ввести понятие отношения сигнал/шум

PC >> PП означает, что . Тогда

Полученная формула отражает предельную скорость мощного сигнала в канале связи. Если PC << PП, то с стремится к нулю. То есть сигнал принимается на фоне помех. В таком канале в единицу времени сигнал получить не удается. В реальных ситуациях полностью помеху отфильтровать нельзя. Поэтому приемник получает полезную информацию с некоторым набором ошибочных символов. Канал связи для такой ситуации можно представить в виде, изображенном на рис. 7, приняв источник информации за множество передаваемых символов {X}, а приемник – за множество получаемых символов {Y}.

Рис.7 Граф переходных вероятностей K- ичного канала связи

Между существует определенное однозначное соответствие. Если помех нет, то вероятность однозначного соответствия равна единице, в противном случае она меньше единицы.

Если qi – вероятность принятия yi за xi, a pij = p{yi / xi} – вероятность ошибки, то

.

.

Граф переходных вероятностей отражает конечный результат влияния помехи на сигнал. Как правило, он получается экспериментально.

Полезная информация может быть оценена как IПОЛ = nH(X · Y), где n – количество элементарных символов в сигнале; H(X · Y) – взаимная энтропия источника X и источника Y.

В данном случае источником X является источник полезной информации, а источником Y является приемник. Соотношение, определяющее полезную информацию, можно получить исходя из смысла взаимной энтропии: заштрихованный участок диаграммы определяет сообщения, переданные источником Xи полученные приемником Y; незаштрихованные участки отображают сигналы источника X, не дошедшие до приемника и полученные приемником посторонние сигналы, не передаваемые источником.

B – скорость генерации элементарных символов на выходе источника.

Для получения max нужно по возможности увеличить H(Y) и уменьшить H(Y/X). Графически эта ситуация может быть представлена совмещением кругов на диаграмме (Рис. 2г).

Если же круги вообще не пересекаются, X и Y существуют независимо друг от друга. В дальнейшем будет показано, как можно использовать общее выражение для максимальной скорости передачи при анализе конкретных каналов связи.

Характеризуя дискретный канал, используют два понятия скорости: техническая и информационная.

Под технической скоростью передачи RT, называемой также скоростью манипуляции, подразумевают число символов (элементарных сигналов), передаваемых по каналу в единицу времени. Она зависит от свойств линии связи и быстродействия аппаратуры канала.

С учетом различий в длительности символов техническая скорость определяется как

где - среднее время длительности символа.

Единицей измерения служит »бод» - это скорость, при которой за одну секунду передается один символ.

Информационная скорость или скорость передачи информации определяется средним количеством информации, которое передается по каналу за единицу времени. Она зависит как от характеристик конкретного канала (таких как объем алфавита используемых символов, технической скорости их передачи, статистического свойства помех в линии), так и от вероятностей поступающих на вход символов и их статистической взаимосвязи.

При известной скорости манипуляции скорость передачи информации по каналу задается соотношением:

![]() ,

,

где – среднее количество информации, переносимое одним символом.

Для практики важно выяснить, до какого предела и каким путем можно повысить скорость передачи информации по конкретному каналу. Предельные возможности канала по передаче информации характеризуются его пропускной способностью.

Пропускная способность канала с заданными переходными вероятностями равна максимуму передаваемой информации по всем входным распределениям символов источника X:

![]()

С математической точки зрения поиск пропускной способности дискретного канала без памяти сводится к поиску распределения вероятностей входных символов источника Х, обеспечивающего максимум переданной информации . При этом, на вероятности входных символов накладывается ограничение: ![]() , .

, .

В общем случае, определение максимума при заданных ограничениях возможно с помощью мультипликативного метода Лагранжа. Однако такое решение требует чрезмерно больших затрат.

В частном случае для дискретных симметричных каналов без памяти пропускная способность (максимум , достигается при равномерном распределении входных символов источника X.

Тогда для ДСК без памяти, считая заданной вероятность ошибки ε и для равновероятных входных символов = = = =1/2, можно получить пропускную способность такого канала по известному выражению для :

где = – энтропия двоичного симметричного канала при заданной вероятности ошибки ε.

Интерес представляют граничные случаи:

1. Передача информации по бесшумному каналу (без помех):

![]() , [бит/символ].

, [бит/символ].

При фиксированных основных технических характеристиках канала (например, полосе частот, средней и пиковой мощности передатчика), которые определяют значение технической скорости, пропускная способность канала без помех будет равна [бит/сек].

Пропускная способность дискретного канала без помех

Определим пропускную способность канала как максимальное количество информации, которое можно передавать по нему в единицу времени:

C = max{Ixy}/ tx (бит/с) (4.1)

Для канала без помех справедливо условие I xy = H x , а потому его пропускная способность:

C бп = max{Hx}/ tx = log 2 m / tx (4.2)

В частном случае передачи двоичных разрядов (m = 2) справедливо

С бп = 1/tx (4.3).

Для нас важно, как соотносится величина С бп с потоком информации источника H`z , который определяется по формуле

H`z = Hz/tz (бит/с) (4.4).

Пропускная способность канала используется полностью, когда H`z = C. Между тем, уменьшение энтропии Hz может привести к сокращению информационного потока. Чтобы его увеличить, требуется сократить время tz . Если учесть, что

tz = tx * lср, где lср - средняя длина кода символа, то становится ясно: чтобы полнее использовать пропускную способность канала для любого источника, нужно рационально кодировать сообщения, по возможности сокращая величину lср .

Если записать условие полного использования пропускной способности канала H`z = C в развернутом виде, то для канала без помех оно будет иметь вид:

Hz/tz = log 2 m/tx (4.5),

а с учетом tz = tx * lср и log 2 m = 1 (при m=2) мы получим условие:

lср = Hz (4.6)

По сути, доказательство этой так называемой теоремы Шеннона о кодировании для канала без помех сводится к нахождению процедуры, позволяющей получить требуемый код. Эта процедура, именуемая эффективным кодированием, была предложена самим Шенноном и в дальнейшем усовершенствована (с точки зрения удобства ее практического применения) Хаффменом.

В обоих случаях речь идет о посимвольном кодировании и величина Hz имеет значение безусловной энтропии. В принципе можно пойти дальше и рассматривать кодирование цепочек символов. В этом случае Hz будет иметь смысл условной энтропии порядка l, где l - максимальная длина цепочки. О "цепочечном" кодировании речь впереди, а пока мы рассмотрим классический подход к эффективному кодированию на уровне символов.

Рассмотрим теперь вариант, когда помехи в канале вызывают появление ошибок с вероятностью p 0 . В этом случае из соотношения 3.1 следует:

C = max {Hx - Hx/y}/ tx = (log 2 m - Hx/y) / tx (4.8)

Рассмотрим наиболее распространенный случай так называемого двоичного симметричного канала. При этом m = 2 (log 2 m = 1), а вероятности ошибки “переход "1" в "0” ” “переход "0" в "1" ” одинаковы.

Если теперь рассмотреть в качестве случайного события передачу разряда кода с ошибкой (вероятность p 0), то, используя формулу (2.8) для определения энтропии, получим:

Hx/y = Hy/x = -p 0 log 2 p 0 - (1 - p 0) log 2 (1 - p 0) (4.9)

С учетом этого (4.8) преобразуется к виду:

C = /tx (4.10)

Таким образом, пропускная способность симметричного двоичного канала с помехами определяется только скоростью передачи разрядов кода (Vx = 1/tx) и вероятностью ошибок.

Наглядно зависимость C(p 0) иллюстрирует рисунок 2.

Рисунок 2

Как видно, максимальное значение пропускной способности канала достигается при p 0 = 0 «канал без помех»и при p 0 = 1 (очевидно, что если канал передает все символы с ошибками, то последние легко устраняются инвертированием). Минимальное значение C = 0 имеет место при p 0 = 0.5.

Шеннон показал, что за счет кодирования пропускную способность канала с помехами также можно использовать максимально полно (напомним, что сама она будет ниже, чем у канала без помех).

Способ кодирования, который позволяет этого добиться, основан на использовании избыточных кодов, когда каждый информационный блок защищается контрольными разрядами и чем больше длина блока, тем меньше удельный вес этих избыточных разрядов, позволяющих обнаружить и исправить ошибки. Вопросы применения корректирующих кодов мы рассмотрим в разделе 5.

Значение слова неудачный

Обзор Samsung Galaxy A7 (2017): не боится воды и экономии Стоит ли покупать samsung a7

Делаем бэкап прошивки на андроиде

Как настроить файл подкачки?

Установка режима совместимости в Windows